Dit is een verhaal dat een aantal kanten op uitwaaiert omdat het over een gelaagde werkelijkheid gaat.

Het verhaal is gebaseerd op de MIT Technology Review van 04 december 2020 .

Het artikel is te vinden op www.technologyreview.com/2020/12/04/1013294/google-ai-ethics-research-paper-forced-out-timnit-gebru/?truid=17ea3c5617f2127d84996cc1fb99d190&utm_source=the_download&utm_medium=email&utm_campaign=the_download.unpaid.engagement&utm_term=&utm_content=12-07-2020&mc_cid=527e2538d4&mc_eid=4c1d1315ec . Een podcast is te vinden op https://playlist.megaphone.fm/?e=MIT6337087016 .

Natural Language Processing (NLP)

Techondernemingen willen graag dat hun software zo goed mogelijk natuurlijke taal begrijpt en uitingen kan doen die daar zo dicht mogelijk in de buurt komen.

Dat doen ze met Artificial Intelligence (AI) die draait op computers met een neurale netwerk-structuur.

Als je een neurale netwerk-computer wilt leren om kattenplaatjes te herkennen, voer je heel veel foto’s van katten toe en iedere kaar vertel je tegen de computer achteraf of dit wel of geen kat was. Dat heet trainen. In de krochten van het namaakbrein gebeurt iets in de sfeer van groeiende en krimpende verbindingen (wat precies, weet niemand) en na voldoende training weet de computer voortaan met grote precisie bij een nieuw plaatje of het wel of geen kat is.

Dat werkt mogelijk ook voor uitstrijkjes en het vouwen van eiwitten en andere goede doelen, en soms zijn die programma’s heel goed.

Natuurlijke taal is heel wat ingewikkelder als een kattenplaatje of een uitstrijkje. Het vraagt hele zware computers, heel veel tijd en heel veel tekst en heel veel deskundigheid.

Waaronder ethische deskundigheid, want namaaktaal is riskante business.

Grote NLP-modellen vreten stroom

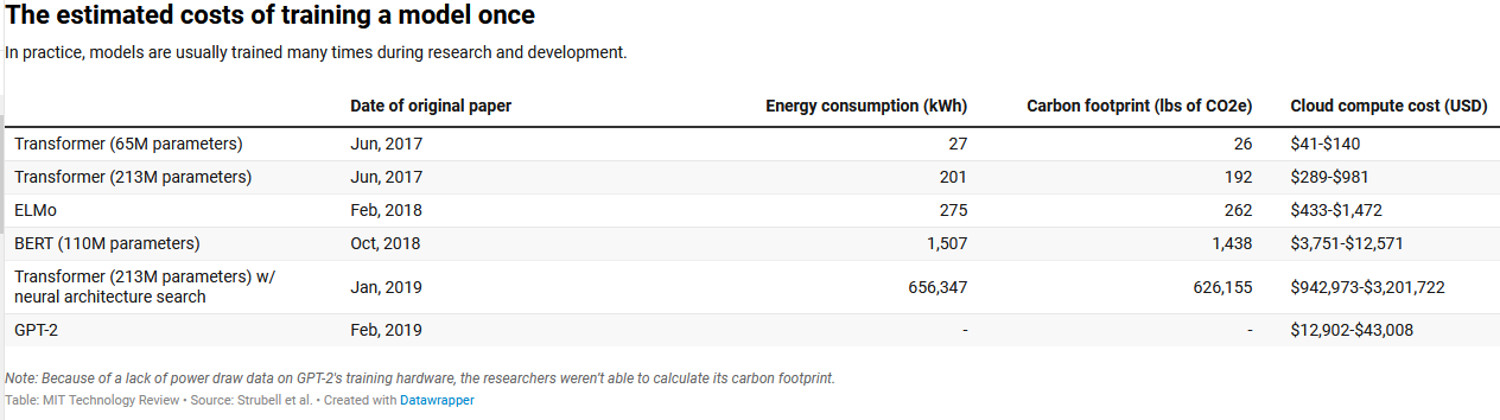

In een artikel dd 5 juni 2019 hebben de Amherst-onderzoekers Emma Strubell, Ananya Ganesh en Andrew McCallum uitgerekend wat een trainingssessie energetisch betekende ( zie Energy and Policy Considerations for Deep Learning in NLP, https://arxiv.org/abs/1906.02243 ).Dat bleek interessant.

Onderzocht werden Transformer, ELMo, BERT en GPT-2.

ELMo is een soort basisprogramma dat de betekenis van woorden in hun context kan coderen (https://allennlp.org/elmo ) . Het is Open Source.

Transformer is door Google ontwikkeld en BERT is daar de zoon van. BERT is het programma dat Google gebruikt om menselijke vragen op zijn zoekmachine te snappen (https://blog.google/products/search/search-language-understanding-bert/ ). Het is hun cash cow.

GPT-2 is Open AI .

Neural Architecture Search (NAS) is een techniek om het ontwerp van neurale netwerk-computers te automatiseren (https://en.wikipedia.org/wiki/Neural_architecture_search ).

Dat veel namen uit Sesam straat lijken te komen, was in het begin toeval en daarna traditie als de ene wetenschapper voortbouwde op de andere.

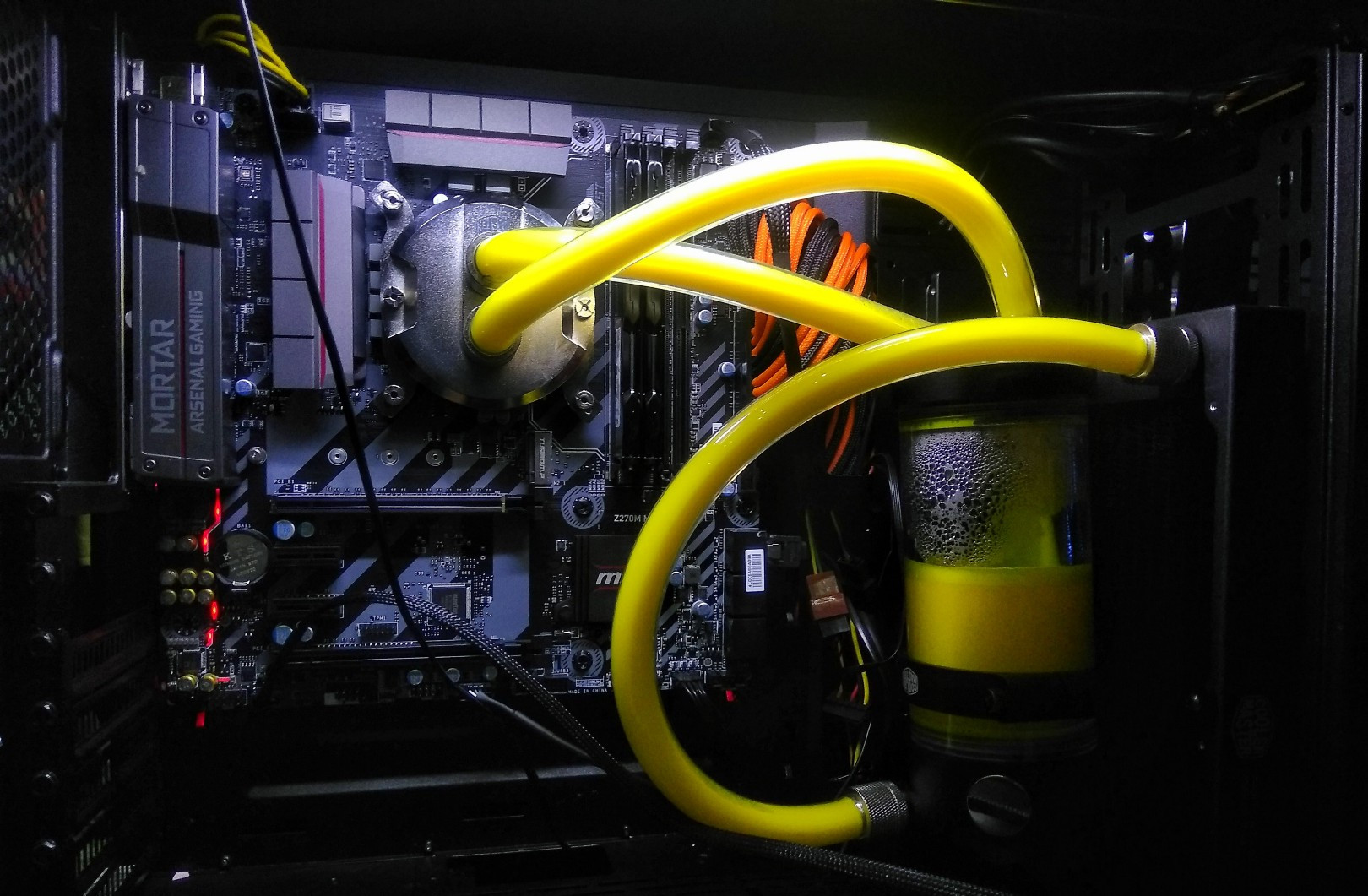

Men liet de programma’s een dag draaien op één GPU (een Graphics Processing Unit, een goed uitlegartikel op https://towardsdatascience.com/what-is-a-gpu-and-do-you-need-one-in-deep-learning-718b9597aa0d ) om het gevraagde vermogen te meten, en berekenden daarna, op basis van het aantal uren dat het model voor een taak specificeerde, wat één volledige trainingssessie aan stroom kostte.

Een trainingssessie t.b.v. Google’s BERT kostte 1507kWh . Dat is nog te overzien: het is het jaarlijkse elektriciteitsverbruik van ongeveer een half Nederlands huishouden of zowat een vliegretourtje New York – San Francisco.

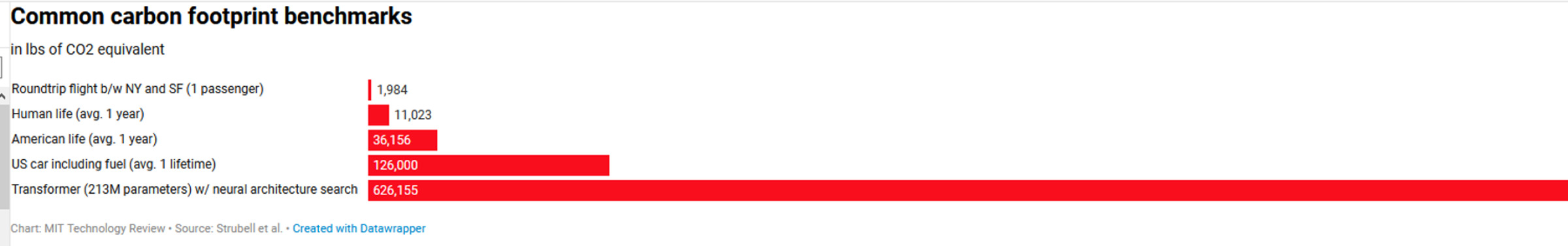

Wordt het ingewikkelder (meer parameters en en de NAS-procedure erbij) dan ontploft het energieverbruik dramatisch naar bijvoorbeeld ruim 656000 kWh: het jaarlijkse stroomverbruik van 220 Nederlandse huizen (en dat voor één trainingssessie). Bij de in de VS gebruikelijke stroommix is dat 626155 lb CO2 (dat is 284 ton).

Het wordt sappig in kaart gebracht met bovenstaand diagram: een gemiddelde Amerikaanse auto produceert over zijn levensduur (Brandstof en fabricage samen) ongeveer 126000 lbs CO2 . Een opgepompte trainingssessie is goed voor vijf Amerikaanse auto’s, genomen over hun gehele levensduur. Enz.

Bovenstaand is een ondergrens omdat modellen vaker dan één keer getraind worden, en uiteraard omdat er straks een heleboel bezitters van zo’n model zijn.

Timnit Gebru

Hier komt Timnit Gebru in beeld.

De ouders van Timnit Gebru komen uit Eritrea, zijn naar Ethiopië gevlucht waarna Timnit Gebru geboren en opgegroeid is in Addis Abeba. Uiteindelijk is het gezin in de VS aangekomen, waar Timnit Gebru afgestudeerd is aan Stanford in de elektrotechniek. ( https://en.wikipedia.org/wiki/Timnit_Gebru ).

Ze heeft zich als wetenschapper ontwikkeld tot een mondiaal toonaangevende authoriteit op het gebied van Data mining en de ‘Bias’ (zoiets als ingebakken vooroordelen en verborgen selectiekeuzes) daarvan . Het is de basis voor “AI Ethics”.

Van haar is bijvoorbeeld de observatie dat als je met Google Street View in een woonwijk meer pickup trucks zag dan sedans, die wijk met grote waarschijnlijkheid Republikeins stemde.

En ook de observatie dat het gezichtsherkenningssysteem van Amazon meer moeite had met gezichten van donkere vrouwen dan elk ander gezichtsherkenningssysteem. Ze meent dat op dit moment gezichtsherkenning een te gevaarlijke techniek is om voor juridische en veiligheidsdoelen te gebruiken.

Maatschappelijk heeft ze haar afkomst niet verloochend. Ze is altijd voor diversiteit blijven strijden en bijvoorbeeld het Black in AI – platform opgericht.

Het dienstverband bij Google ging lang goed. Ze werd er zoiets als hoofd Ethische Zaken.

Bij Google werkt een van de meest diverse AI-teams ter wereld. Timnit Gebru heeft meegewerkt aan tientallen papers en ze werd er de beroemdheid zie ze nu is.

By TechCrunch – https://www.flickr.com/photos/techcrunch/30671211838/, CC BY 2.0, https://commons.wikimedia.org/w/index.php?curid=97266712

Maar toen ging het fout. De details van het arbeidsconflict zijn (althans dd 4 dec 2020) niet bekend omdat beide partijen er (tot dan) over zwegen.

Desalniettemin resoneerde het ontslag (al dan niet vrijwillig) over de hele wereld. Ruim 1400 mensen binnen Google en ruim 1900 erbuiten tekenden een protestbrief.

De nadelen van grootschalige Natural Language Processing

Wel duidelijk is dat het om een nog niet officieel gepubliceerd paper ging met de fraaie naam “On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?” en het benoemde vier wezenlijke nadelen van de grote NLP-programma’s waar Google aan werkt.

Dat bleek uit de eerder genoemde MIT Technology Review van 4 december. De redactie heeft het paper niet gepubliceerd, omdat het een nog eerste versie was, en omdat vier medeauteurs, die nog bij Google werken, hun naam liever niet bekend zagen. Een vijfde auteur, Emily Bender, heeft een vaste aanstelling aan de Universiteit van Washington en had niet wat te vrezen bij het geven van inzage in de tekst (een voordeel van academische vrijheid).

Zodoende kon er een samenvatting naar buiten gebracht worden.

- Grote modellen kosten vreselijk veel energie en geld.

Dat is oneerlijk. Grote rijke instellingen kunnen NLP betalen, maar de klimaateffecten worden vooral gedragen door arme gemeenschappen. - Grote modellen vreten voor hun training onbeheersbaar veel data, zijnde teksten. Researchers voeren de datahonger vanuit het Internet en het is daarom niet uit te sluiten dat er ook een hoop rascistische en sexistische taal naar binnen gulpt.

Landen en gemeenschappen die minder toegang hebben tot Internet blijven ondervertegenwoordigd, evenals bewegingen als Black Lives Matter en MeToo, die op subtiele wijze een eigen woordgebruik hebben op gebouwd.

Een mooi stukje sociolinguïstiek in de praktijk. - De meeste AI-onderzoekers erkennen dat grote NLP-modellen taal niet echt begrijpen, maar vooral manipuleren (en dat doen ze heel goed). Dat gaat geld opbrengen en daarom investeert de Big Tech erin. Het kritische paper kwam even niet zo goed uit.

Men zou ook kunnen investeren in AI die taal begrijpt, minder energie verbruikt en met kleinere datasets werkt die beter voor te bewerken zijn voor ze naar binnen geslurpt worden. Het niet-gepubliceerde paper bevat volgens Bender aanzetten in die richting. - De geproduceerde taal is goed genoeg om betrouwbaar te lijken, maar niet om het werkelijk te zijn. Een vertaalnetwerk van Facebook vertaalde in 2017 het Arabische ‘Goede morgen’ van een Palestijn in ‘Val ze aan’ in het Hebreeuws en dat resulteerde in zijn arrestatie.

Het menselijke zenuwstelsel

Anderhalf pond levend weefsel levert spelenderwijs goed taalgebruik en verbruikt ca 200kWh per jaar.